アリゼ、MLセールスエンジニア、カム・ヤング

顧客サービスの品質向上から、創薬の迅速化まで、生成AIは急速に業界の常識を変化させ続けています。

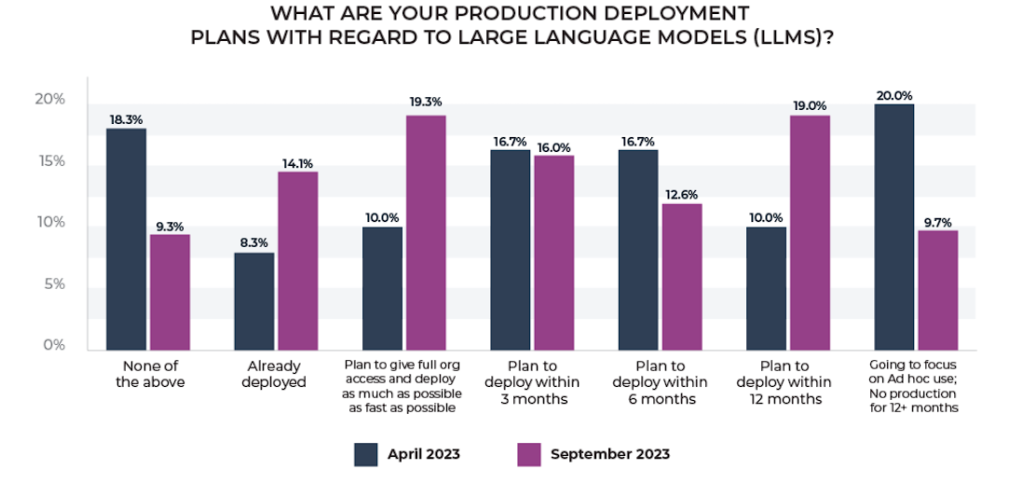

最近の調査によると、企業のエンジニアリングチームの61.7%が、1年以内に大規模言語モデルのアプリケーションを導入している・導入する予定であり、4月の8.3%に比べ、10分の1以上(14.7%)がすでに実稼働しています。

導入のスピードが速いことを考えると、初期のギャップによる苦痛は避けられません。

LLMを早期に導入した企業の半数近く(43%)が、評価、幻覚、不必要な抽象化といった問題を導入の課題として挙げています。大企業がこのような課題を克服して成果を上げ、組織のリスクを最小限に抑えるにはどうすればよいのでしょうか。

ここでは、LLMの導入に成功している企業が、この課題を克服するために採用している3つのカギを紹介します。

変化する状況への不可知論的アプローチ

エンジニアリングチームが、1つの基盤モデル(例:OpenAIのGPT-4)やオーケストレーション・フレームワーク(例:LangChain)にしか接続できないインフラを構築するのに1ヶ月という期間を費やしてしまうことを仮定します。

そうしたら、すぐに自分たちの仕事、あるいはビジネス戦略全体が時代遅れになってしまうリスクが生じてしまいます。

企業のLLM可観測性とスタックが不可知論的であり、主要な基礎モデルとツールに簡単に接続できることを保証することで、切り替えコストと摩擦を最小限に抑えることができます。

LLM科学実験の運用化

ファウンデーションモデルプロバイダーが独自のエバリュエーション(事実上、宿題の採点)を提供するこの分野では、独立したLLM評価を開発または活用することが重要です。

ArizeのLLM評価ツールやその他のツールは、LLMを客観的にナビゲートすることができます。この客観性は、データサイエンティストと機械学習プラットフォームエンジニアのチームと相まって、組織がLLMユースケースのために何百もの科学実験を迅速に自動化し、運用するための強固な基盤を提供し、生産における信頼性と企業全体におけるAIの責任ある使用を保証することができます。

ROIと生産性向上の定量化

モデルの複雑さと新規性を考慮すると、生成AIの実装は困難で時間がかかる可能性があります。

収益に影響を与えるLLMアプリのパフォーマンスの問題を検出するためのシステムを確実に存在させること(根本的な原因を積極的かつ自動的に浮上させるための関連ワークフローを含む)は特に重要です。ここで、オープンソースやその他のツールは、UMAP、スパン、トレース、プロンプト・プレイグラウンドなどのようなインタラクティブでガイド付きのワークフローを通じて、混乱を最小限に抑えるのに役立ちます。

結論

生成AIが進化を続ける中、LLMアプリを確実かつ責任を持ってデプロイする義務と、現代特有の競争圧力を考慮したスピード感とのバランスを取るのは難しいかもしれません。

今回ご紹介した、大規模言語モデルの運用(LLMOps)の展望をナビゲートするための3つの鍵が、あなたの役に立つことを願っています!