生成AIが現代の企業を再構築しています。

最近の調査によると、開発者の半数以上(61%)が、今後1年以内に、あるいは「できるだけ早く」、LLMアプリケーションを本番環境に導入する予定だと答えています。

しかし、生成AIを使ったアプリケーションを本番環境に導入し、そのまま使い続けるには課題が残っているのが現状です。

今週のMicrosoft Buildで、Arize AIは、AIエンジニアがLLMアプリケーションの信頼性の高い開発を加速させるために、Microsoft Azureとの深いパートナーシップ結んだことを公開しました。

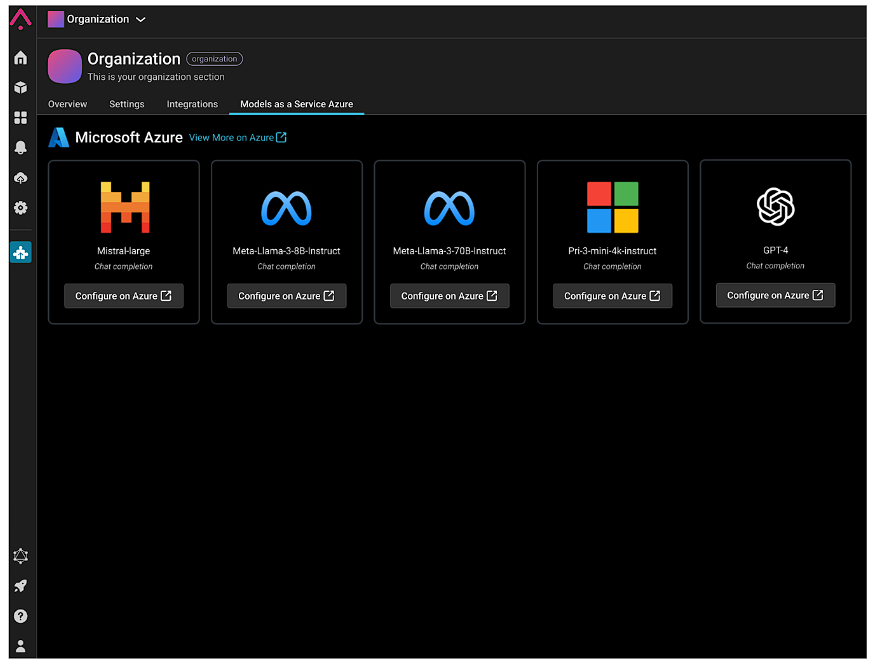

Microsoft Azure Model-as-a-Service

Fortune 500に名を連ねる航空会社、金融サービス企業、小売業者、テクノロジー企業などの多くが、堅牢なMLとLLMの観測可能性のためにArizeとともにAzureを利用しています。

これらのユーザーにとって、Azure AIモデルカタログは素晴らしい出発点となります。

Azure Open AI Service、Meta、Mistral、Cohereなど、Azure AIがキュレーションした人気のオープンソースモデルが掲載されており、Hugging Faceとのパートナーシップを活用して、推論用の数千ものOSSモデルを提供しています。

重要なのは、Azure AIモデルカタログが、Models- as-a-Service (MaaS)を通じて、複数の従量課金型推論APIを提供していることです。AzureがインフラとGPUを管理し、ユーザーがLlama 3、Mistral Large、Cohere Command R/R+、Embedモデルなどの厳選されたモデル群に、LLM用のトークンに基づく課金制の従量課金APIを介してアクセスすることで、ユーザーはGPUをプロビジョニングすることなくホスト型の微調整を行うことが可能になります。

そして、プロンプトフロー、LlamaIndex、ArizeなどのLLMOpsツールとシームレスに統合し、最終的に本番環境への移行を早めることができます。

これらの生成AIの開発プラットフォームで利用可能なMaaSにより、開発者はEnterpriseグレードの従量課金APIを活用しながら、生成AIアプリを構築するために好みのツールを使い続けることができます。これらのAPIは、Azureのデータ、プライバシー、セキュリティのコミットメントの対象であり、Microsoftがあなたの許可なくデータを第三者に共有しないことを保証しています。

プロンプトやレスポンスの内容などは、Azure上のModels as a Serviceを組織で使用することで、生成されるデータを含めお客様のデータはプライベートに保たれ、第三者に開示されることはありません。

ArizeとAzure Model As a Serviceの統合

Arizeは、Arize LLM評価および観測可能性プラットフォームにAzure AI Model as a Serviceを統合しました。

Llama 3やMistral Largeのような使いやすいホストモデルの厳選されたセットへのアクセスをサービスとして提供することで、Azureは生成的AIアプリケーションの構築をこれまで以上に迅速化します。

LLM評価、トレーシング、観測性のための主要なプラットフォームを提供するArize AIとのシームレスな統合により、Azure AI Studioを使用するAIエンジニアや開発者は、洗練されたLLMシステムのエンタープライズグレードのデプロイメントを確実に行うことができます。

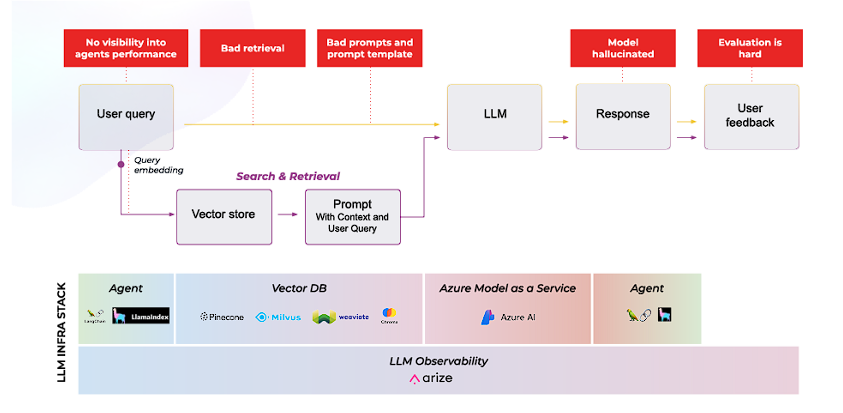

LLM評価と観測可能性の必要性

利用可能なモデルの豊富さと性能のばらつきを考えると、専門的なタスクやユースケースに対する客観的な評価と、LLMアプリが本番稼動した後の問題の検出とトラブルシューティングのための観測可能性が最も重要になります。

これは、適切なモデルを選択し、検索拡張世代(RAG)、Copilot、エージェントなどのユースケースでアプリケーションを動作させることがいかに複雑であるかを考えると、『言うは易く行うは難し』です。

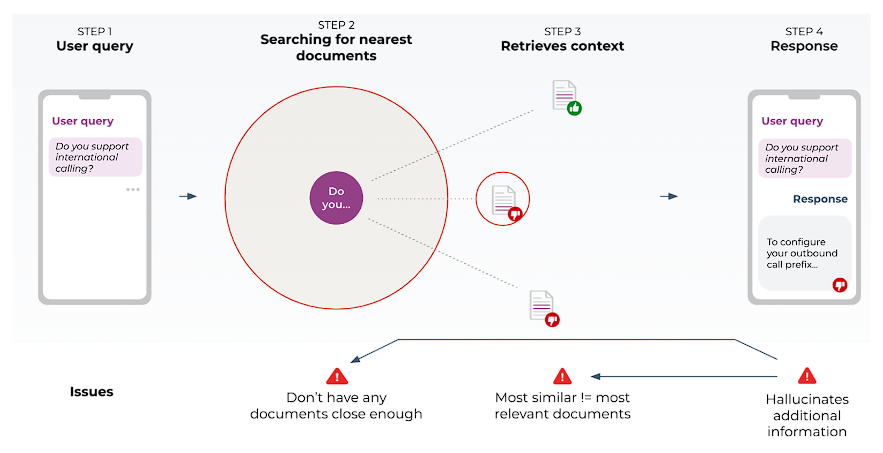

RAGの展開には、個人の顧客データをLLMの生成モデルに接続するために連携する必要のある複雑な技術セットが含まれます。

この技術が実世界に展開される際に発生する問題は、チームにとってトラブルシューティングが困難な場合があります。

不正確な検索、機密データ上の幻覚(ハルシネーション)、不完全な回答の原因となる不完全なコンテキストチャンク、回答するコンテキストデータがない質問などが挙げられます。

このような複雑なAIシステムには、観測と分析のための世界クラスのソリューションが必要です。

このような取り組みがエグゼクティブ・スイートで高い可視性を持つことと相まって、エラーやミスが雪だるま式に増えてPR問題に発展する余地はほとんどありません。

つまり、LLMの観測可能性の必要性は、アプリケーションやサービスにLLMを導入するチームにとって必須なのです。

Arize AIがLLM評価と新しいスタックにわたる、観測可能性を提供

Arize AIはAzure AI Studioとの連携を深め、チームがLLMアプリを客観的に評価し、出力から逆算してLLMスタック全体のどこに問題が生じているのかを正確に突き止められるよう支援します。

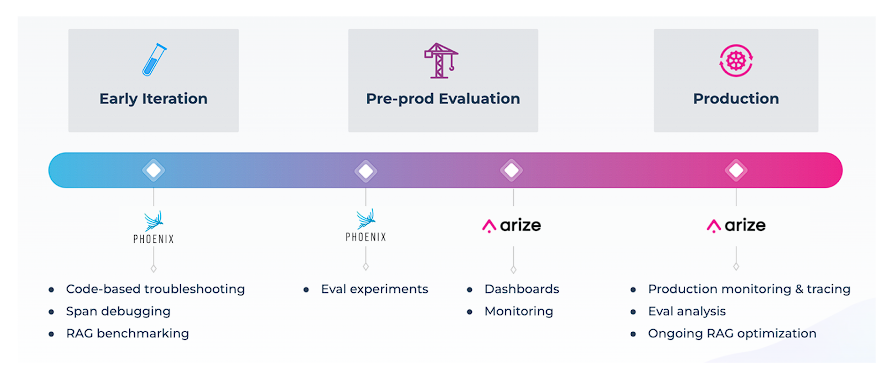

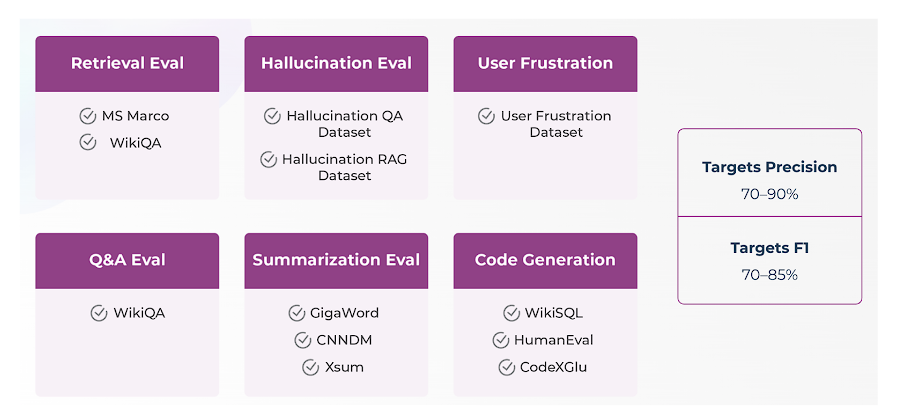

LLM評価については、Arize社のオープンソースライブラリであるPhoenixが、コード生成、文脈関連性、幻覚(ハルシネーション)、Q&Aの正しさ、要約、毒性などの様々なタスクに対して、シンプル、高速、正確なLLMベースの評価を提供します。

すべての評価テンプレートは、LLM evalライブラリのベンチマークデータセットの一部として利用可能なゴールデンデータセットに対してテストされ、70~90%の精度と70~85%のF1を目標としています。

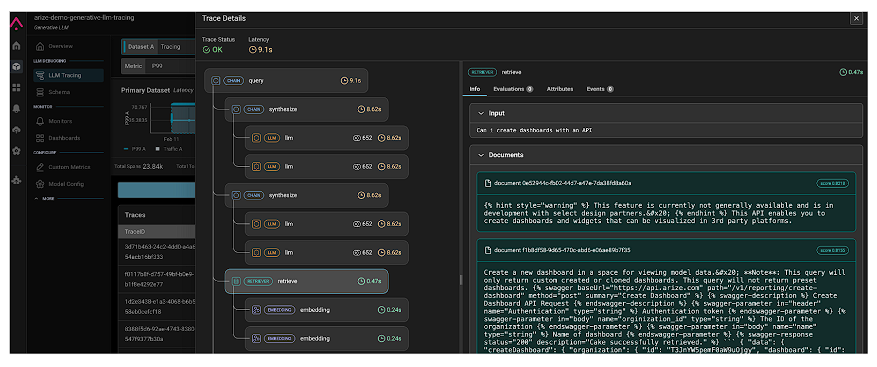

Arizeのプラットフォームは、評価データの収集、検索と取得のトラブルシューティング、LLMアプリチェーンがどこで失敗したかを確認するためのトレースなどの数多くのツールを提供しています。

Arize AI: AzureのためのLLM可観測性

Arize AIの可観測性を持つプラットフォームは、Azure AI Studioを活用するAzure顧客向けのネイティブサポートを特徴としています。

したがって、アプリケーション、プロンプト、レスポンスなど、LLMベースのソフトウェアシステムのすべてのレイヤーに対する完全な可視性を提供しています。

軽量な統合により、チームは、Azureのスタック上に構築されたLLMまたはMLを搭載したアプリケーションのAI観測可能性を簡単に有効にすることができます。

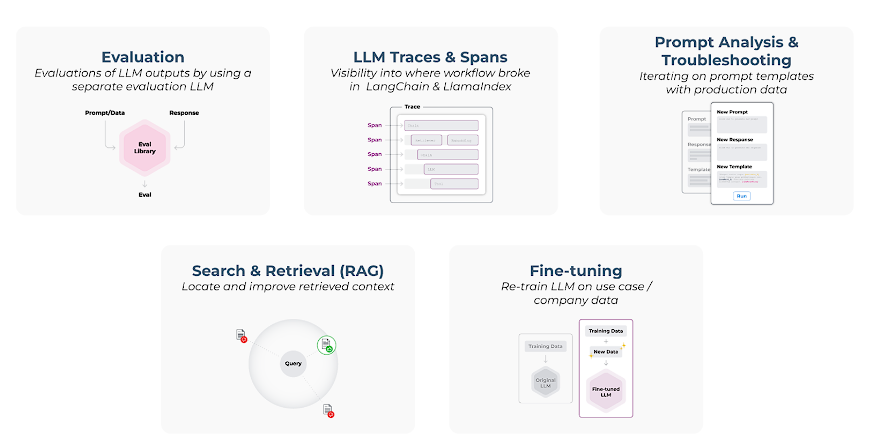

Arize AIのAzureとの共同提供は、LLMの観測可能性の5つの柱をカバーしています。

- LLM評価:Phoenixオープンソースフレームワークは、AzureのAIテクノロジーを支える堅牢で高速なLLM-as-a-judge評価を可能にする。

- 検索拡張生成(RAG): ArizeのトラブルシューティングソリューションとAzure AI Studioを組み合わせることで、プライベートデータを使用して、独自のデータを動力源とするより堅牢なLLMアプリケーションを作成するための強力な手段を生み出す。

- LLMのトレースとスパン: エージェントのトレースとスパンにより、チームはどのコールが失敗したか、またはスパンのどこで問題が発生したかを理解可能。

- 迅速なエンジニアリング: Azure AIモデルカタログは、Arizeのプロンプトプレイグラウンドと簡単に統合でき、チームはプロンプトテンプレートを改善し、リアルタイムで結果を検証しながら反復することが可能。

微調整:Arizeツールを使ってゴールデンデータセットをキュレーションし、微調整のためにAzure AI Studioに統合する。

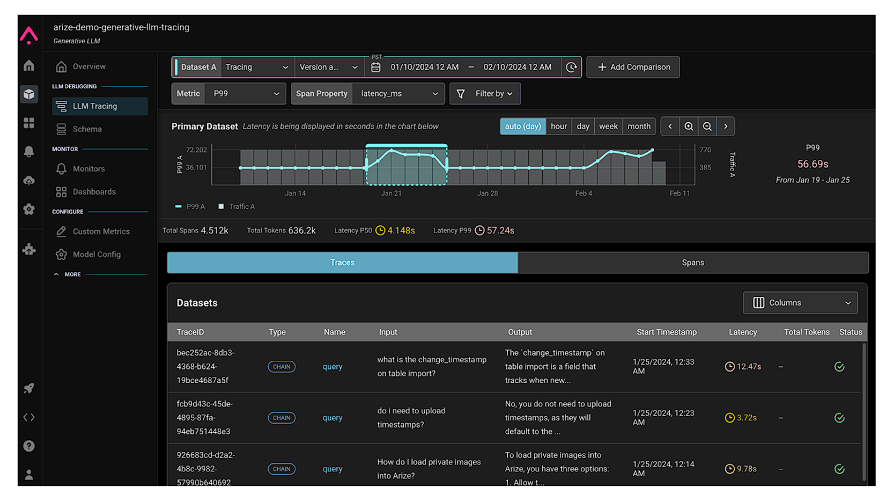

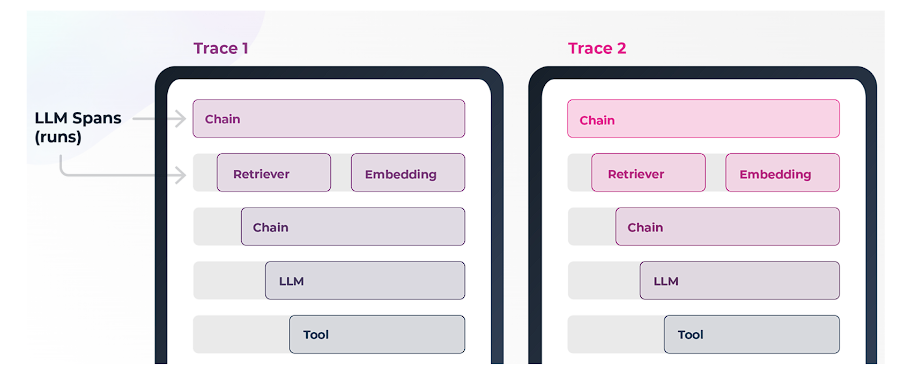

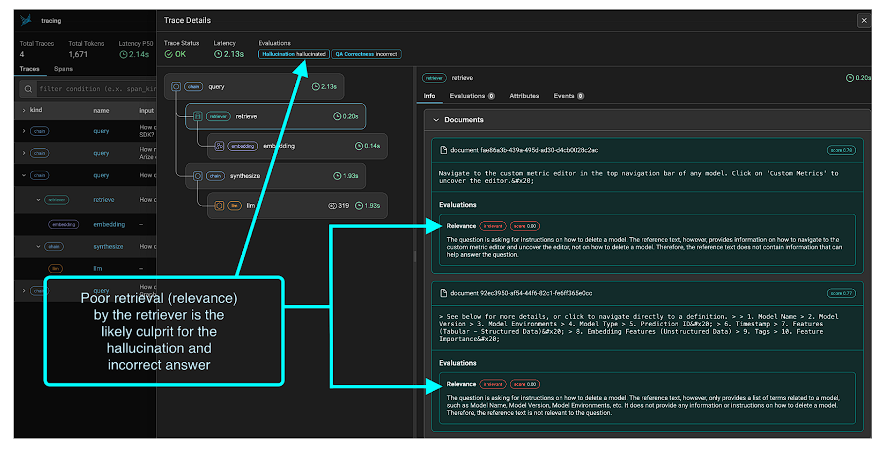

LLM トレースとスパン

デプロイされたチャットBotアプリケーションでは、すべての会話スレッドが、LLMとベクトル検索システムの呼び出しを含む、大量のトレースとスパンを作成します。

これらはLLMアプリケーションをデバッグする上で非常に重要です。以下の単純化した例では、リトリーバー、エンベッディング、ツール、チェーンなどへの呼び出しが示されています。各スパンは特定の仕事をし、各スパンのトラブルシューティングには特定のタイプの評価が必要です。

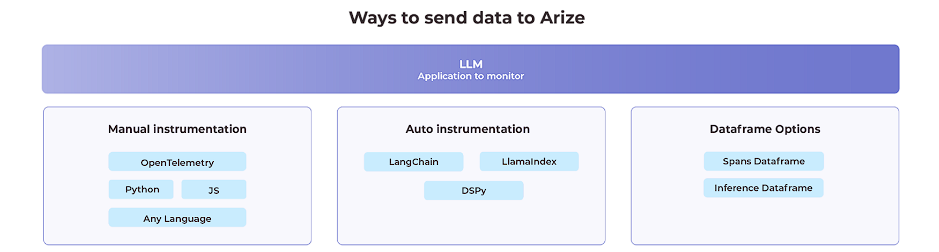

トレースはまず、インスツルメンテーションを使って収集されます。インスツルメンテーションのオプションには、LlamaIndexやDSPyのようなフレームワーク用の自動インスツルメンテーションがあります。

手動計測の場合、PythonSDKデータフレームベースの計測とともに、標準インターフェースを使用したOTEL計測がサポートされています。

チャットBotのインタラクションを駆動する各スパンは、Phoenix OSSで可視化・分析でき、開発フェーズではAzureに永続化されます。

アプリケーションが本番環境に近づくにつれて、ArizeのSaaSプラットフォーム(またはVPC上にデプロイ)にシームレスに移行し、常時監視とトラブルシューティングを行い、問題のあるスパンを自動的に監視することができます。

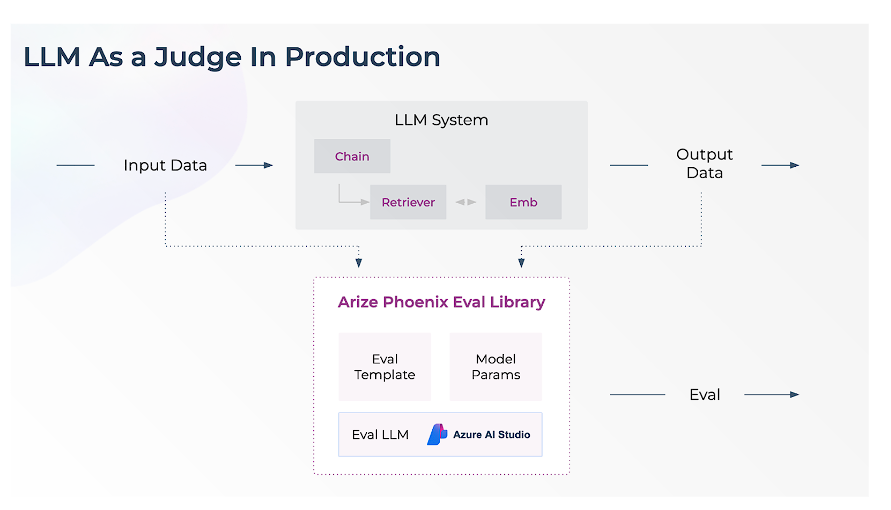

評価者としてのLLM

チームがLLMを大規模に評価する最も重要な方法は『LLM as a judge』と呼ばれるアプローチを使用することです。

Arizeチームによって開発されたPhoenixオープンソース評価ライブラリは、LLM as a judgeを大規模かつ並列に、多くのデータに対して実行するように設計されており、分析のための高品質でテスト済みのテンプレートを提供します。

Azureのお客様は、Azure AIモデルカタログから任意のモデルを評価用LLMとして設定できます。

評価ライブラリには、RAG関連性、Q&A、幻覚(ハルシネーション)検出などの特定のタスク用にあらかじめ設定された評価テンプレートが用意されています。

Arize LLMライブラリは、Azure AIモデルカタログやAzure OpenAI Serviceのモデルを利用し、大規模なデータセット上で実行される検証で並列呼び出しを使用し、高速に設計されています。ライブラリは説明をサポートし、並行性を持つ非同期コールを使用します。以下の機能は、Azure AI Studio全体でサポートされています。

- LLMコールの高速でカスタマイズ可能な並列化

- すべての評価結果に対する説明

- カスタム評価サポートによる独自の評価の持ち込み

- 毒性、人間対AI、関連性、Q&A、引用リンクチェック、検索関連性についての事前テスト済み評価

- コンテキストウィンドウのオーバーフロー

RAGの検索トラブルシューティング

RAGは、企業のプライベートデータをLLMに接続し、生成AIアプリケーションを作成するための重要なコンポーネントです。

RAGを安定的かつ大規模に機能させることは、貴社の製品やサービスにとって差別化されたLLM搭載アプリケーションを構築する上で非常に重要です。

Arizeは、検索プロセスで発生する可能性のあるいくつかの重要な問題を特定する手助けをします。

- 問題のクエリに類似したコンテンツの欠如

- ベクターDBに関連するコンテンツがない

- LLMからの応答に幻覚(ハルシネーション)がある

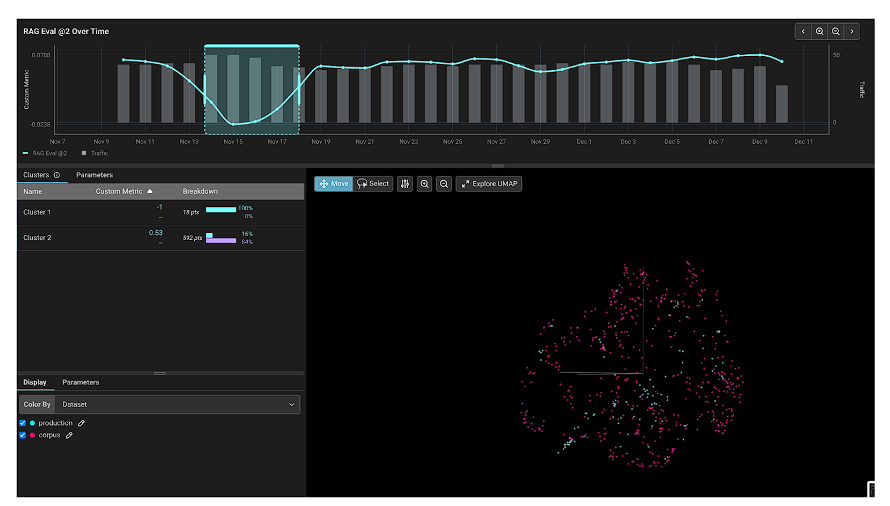

Arizeプラットフォームは、問題のクラスターを検出し、そのクラスターがなぜ検索に問題があるのかを判断し、評価指標に基づいてそのクラスターを分類するのに役立ちます。

ArizeにはRAGトラブルシューティングフローがあり、チャンクの埋め込みとアプリケーションへのクエリの埋め込みを可視化することができます。これらのワークフローは、RAGシステム内の問題のあるクエリー群をピンポイントで特定するための強力なデバッグ機能をチームに提供します。RAGトラブルシューティングワークフローには以下が含まれます。

- プロンプトとチャンクの埋め込み分析

- EVALによって分類されたクエリパフォーマンスのクラスタ

- 関連性評価、Q&A評価、引用リンクの正しさ評価、AI対人間評価

- 評価のモニタリングと生成

- 検索評価の説明

Azure AI StudioとArizeのツール群により、チームは検索結果のベンチマークから本番展開分析まで、数分で検索問題を絞り込むことが可能です。

AzureとArize AIでジェネレーティブAIの新時代を切り拓く

プッシュボタンによるデータ統合に加えて、ArizeプラットフォームにはAzureとの複数の統合ポイントがあります。

Azure AIモデルカタログを経由してModel as a Serviceとして提供される基礎モデルと、ArizeとのLLMトラブルシューティングの組み合わせは、モデルの評価と、本番デプロイのデバッグに必要な機能をお客様に提供し続けていきます。