生成AIは、現代の技術の中でも特に大きな影響を与えるものですが、その可能性と共に責任も大きくなり採用に悩んでる企業も多い。この技術をうまく活用し、社会に良い影響を与えるためには、しっかりとリスクを管理することが大切です。この記事では、生成AIのリスクを減らすための効果的な方法について、セキュリティや法的問題、そして倫理的な側面に焦点を当ててお話ししたいと思います。

歴史から学べることも多いです。過去の技術革新も、当初はリスクが伴っていましたが、私たちはその中で安全策を講じ、改善してきました。例えば、自動車が初めて登場したとき、シートベルトや信号、速度制限などはなく、事故が多発しました。でも、時間とともに社会は対応し、交通ルールや安全基準が整い、今では多くの人が安心して車を使えるようになりました。同じように、生成AIにも今後必要な対策を講じることで、安全に利用できる未来が築けると思います。さて、生成AI関連リスクをまず整理しておきましょう

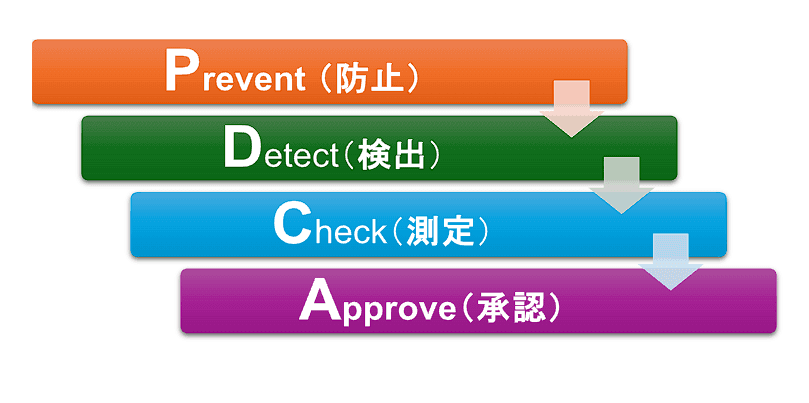

こちらは、生成AIコンテンツに関連する法的リスクを処理するためのシンプルなワークフローで、以下の4つのステップに基づいて構成されています:Prevent防止、Detect検出、Check測定、Approve承認。

1. PREVENT防止 (クリーンデータを使用したトレーニング)

- トレーニング用に、確認済みで法的に準拠した、ライセンスを取得したデータセットからデータを収集・調達します。

- 著作権で保護された情報、機密情報、または個人識別情報(PII)がトレーニングデータに含まれないよう、厳密なデータ審査プロセスを実施します。

- データセットを定期的に監査し、法的および倫理的基準に準拠していることを確認します。例えば、OpenAIやAdobeは、生成AI技術を用いる際に、どのようにして著作権を保護し、著作権侵害を防ぐかに焦点を当てています。特にAdobeは「Content Authenticity Initiative(CAI)」を通じて、デジタルコンテンツのオリジン(出所)を保証する取り組みを推進しています

2. DETECT検出 (コンテンツの分解)

- AIを活用したツールを使用して、生成されたコンテンツを分析し、著作権に関する問題やプライバシー侵害などの法的問題を検出します。

- AI生成の出力をテキスト、画像、コードなどの小さな要素に分解し、盗用や保護されたデータの意図しない使用を確認します。

- 高い類似度スコアや問題のある要素を持つコンテンツをレビュー対象としてフラグ付けします。

3. CHECK測定 (許容レベルを用いた定量化)

- コンテンツ生成における類似度の割合、知的財産権の問題、プライバシーの遵守など、法的リスクの許容閾値を定義します。

- 設定された閾値への近接度を計算することで、潜在的なリスクを定量化します(例:許容される類似度スコア)。

- コンテンツが許容レベルに近づいた場合や超えた場合に、それを識別するリスクレポートを生成します。AdobeのCAIやTruepicのようなツールは、デジタルコンテンツのメタデータを分析し、編集履歴や出所を明示することで、コンテンツの真正性を担保することを目指しています。

4. APPROVE承認 (人間による介入とレビュー)

- フラグが付けられたコンテンツに対して、法務チームや専門家がリスクを評価するための人間によるレビュー手順を実装します。

- 法的および倫理的な境界内に収まるように、必要に応じてコンテンツを調整または修正し、モデルの再トレーニングも含めます。

- 法的違反が確認された場合、コンテンツの削除や修正のための明確な手続きを確立します。AdobeのCAIやTruepicのようなツールは、デジタルコンテンツのメタデータを分析し、編集履歴や出所を明示することで、コンテンツの真正性を担保することができます。

このワークフローは、自動化された検出と各重要なステップでの人間による監視を統合することで、生成AIコンテンツ作成における法的リスクを積極的に管理することができるでしょう。もう少しTinEyeとTruepicを確認しましょう。TinEye と Truepic の両方は、デジタルコンテンツの真正性と独自性を確認するためのツールを提供しており、特に著作権侵害、真正性、および誤情報に対する懸念が高まっている生成AIの文脈で役立ちます。これらのツールがAI生成コンテンツの確認にどのように役立つかは以下の通りです:

TinEye:

- 画像の逆検索: TinEye は、ユーザーが画像をアップロードし、その画像や類似の画像をウェブ上で検索することを可能にします。これにより、AI生成コンテンツが既存の画像から派生しているかどうかを特定し、生成AIモデルが許可なく著作権で保護された素材を使用している場合を見つけるのに役立ちます。

- 画像の使用状況追跡: TinEye は、ユーザーが自分のコンテンツがインターネット上でどのように使用されているかを見るのを助けます。これにより、生成AIモデルがユーザーの画像を不正に利用していないか確認することができます。クリエイターは、不正使用を監視することで知的財産を保護できます。

- 派生作品の発見: 生成AIが元の画像をわずかに変更した場合、TinEye のマッチング技術は、その変更されたバージョンを見つけるのに役立ち、AIが元の画像に基づいて派生作品を作成したかどうかを追跡するのが容易になります。

Truepic:

- 真正性の確認: Truepic は、写真やビデオが元々提示された通りに撮影されたことを確認することに特化しています。AI生成コンテンツの場合、Truepic の技術は画像が操作されたり完全に生成されたものであるかを確認し、リアルと作成されたコンテンツを区別するのに役立ちます。

- メタデータの認証: Truepic は、画像を撮影した時間、場所、およびデバイスなどのメタデータを安全に検証します。これは視覚メディアの信頼性を確立する際に重要です。生成AIは、現実的なフェイクを作成するためにそのようなメタデータを削除または操作することがよくあるためです。

- ブロックチェーン統合: Truepic はブロックチェーン技術を使用して、画像やビデオが撮影された後、その整合性が保たれるようにします。これにより、AI がメディアに無許可の変更を加えることを防ぎ、コンテンツがそのライフサイクル全体で信頼できるものとして保たれることを保証します。

### 結論

AIが生成するコンテンツに対する知的財産権の問題は複雑で、企業やクリエイターにとって重大な課題となっています。著作権侵害のリスクを軽減し、コンテンツの信頼性を確保するためには、AI時代のPDCA(Prevent, Detect, Check, Approve)の採用検討が第一歩かも知らない。

References

- OpenAI’s approach to intellectual property rights: https://openai.com/policies/copyright

- Adobe’s ethical AI and copyright initiatives: https://www.adobe.com/trust/ai-ethics.html

- Content Authenticity Initiative by Adobe: https://contentauthenticity.org/

- Facebook’s AI for trust and authenticity: https://about.fb.com/news/2020/02/ai-fake-news/

- Truepic’s image authenticity technology: https://www.truepic.com/technology

- Adobe’s CAI collaboration with Facebook: https://contentauthenticity.org/collaborators/meta

- Microsoft’s AI content indemnification policies: https://www.microsoft.com/en-us/ai/responsible-ai

- Google’s AI content indemnification policies: https://cloud.google.com/legal/ai/indemnity

- Pixsy for copyright protection in photography: https://www.pixsy.com/

- TinEye reverse image search for copyright checking: https://tineye.com/

- Copyscape for website content copyright: https://www.copys